Dopo l’analisi compiuta nel 2021 e riportata all’interno dell’articolo “Stanno aumentando sulla rete i video di violenza sugli animali“, si è deciso di tornare sull’argomento a distanza di qualche anno per capire in che modo la situazione è cambiata.

Il fenomeno

Il fenomeno descritto riguarda la produzione di video di morte violenta ai danni di qualsiasi tipo di animale (cani, gatti, topi, insetti, etc…); gli animali vengono ripresi mentre vengono uccisi con metodi particolarmente brutali. Per ragioni di decoro si preferisce non entrare nei dettagli ma è importante capire che parte di queste modalità sono direttamente collegate alla sfera sessuale e pertanto gli acquirenti di questi video cercano una forma di eccitazione estrema. Nell’articolo del 2021 si denunciava che il fenomeno era in aumento, benché confinato all’interno di piattaforme di difficile controllo quali quelle peer-to-peer o forum non troppo conosciuti. Purtroppo il fenomeno, negli ultimi anni, è riuscito a penetrare all’interno dei social network, andando ad intaccare un pubblico ben più ampio.

Instagram: adulti, bambini e animali.

L’intelligenza artificiale sta consentendo di creare immagini virtuali particolarmente complesse che, nel caso trattato dal presente articolo, prevedono scene di violenza ai danni di animali. Queste immagini vengono prodotte, per lo più, da paesi est-asiatici e interessano anche persone, non solo animali. Fintanto che le immagini risultano essere artefatte si ritiene che esse non siano un problema e questa considerazione non andrebbe affatto sottovalutata: il trend di generazione di alcune immagini, nei mesi da gennaio 2024 a giugno 2024 ha interessato inizialmente i soli adulti, poi sono state create immagini che raffiguravano scene di violenza contro gli anziani, poi sono stati utilizzati gli animali e infine anche i bambini. Interi canali instagram sono stati creati intorno a queste immagini che, essendo di fatto generate con intelligenza artificiale, non sono considerate “un pericolo”.

In realtà queste immagini hanno il potere di cambiare la percezione della violenza dell’individuo, riducendo la soglia d’intolleranza nei confronti dei contenuti inappropriati. Se inizialmente le immagini generate alludevano ad una o più fantasie sessuali, che il fruitore doveva successivamente realizzare nella sua mente, ora i contenuti sono diventati decisamente più espliciti e molto meno immaginabili. Il cambiamento è stato così tanto graduale che molti visitatori dei canali si sono “abituati” e hanno “gradito” il cambio dei contenuti mantenendo il following nonostante essi risultino fortemente inappropriati.

Perchè est-Asia

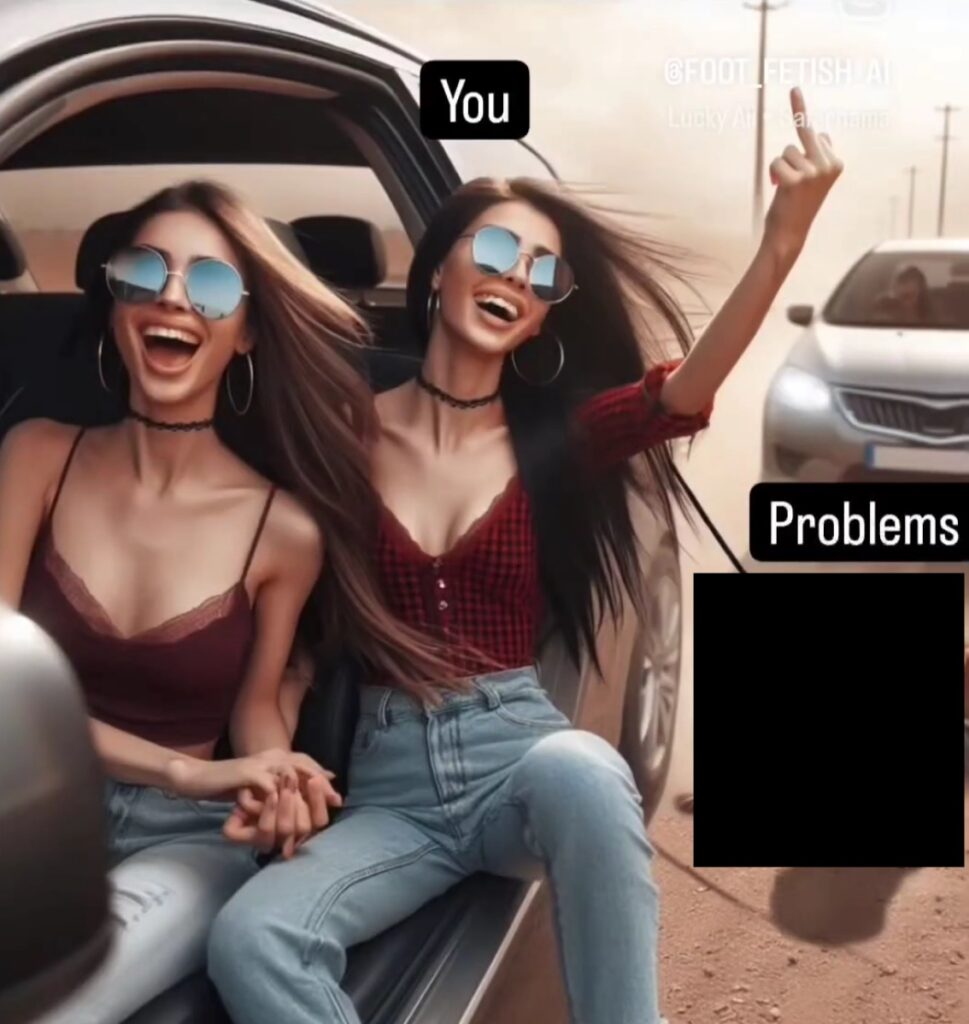

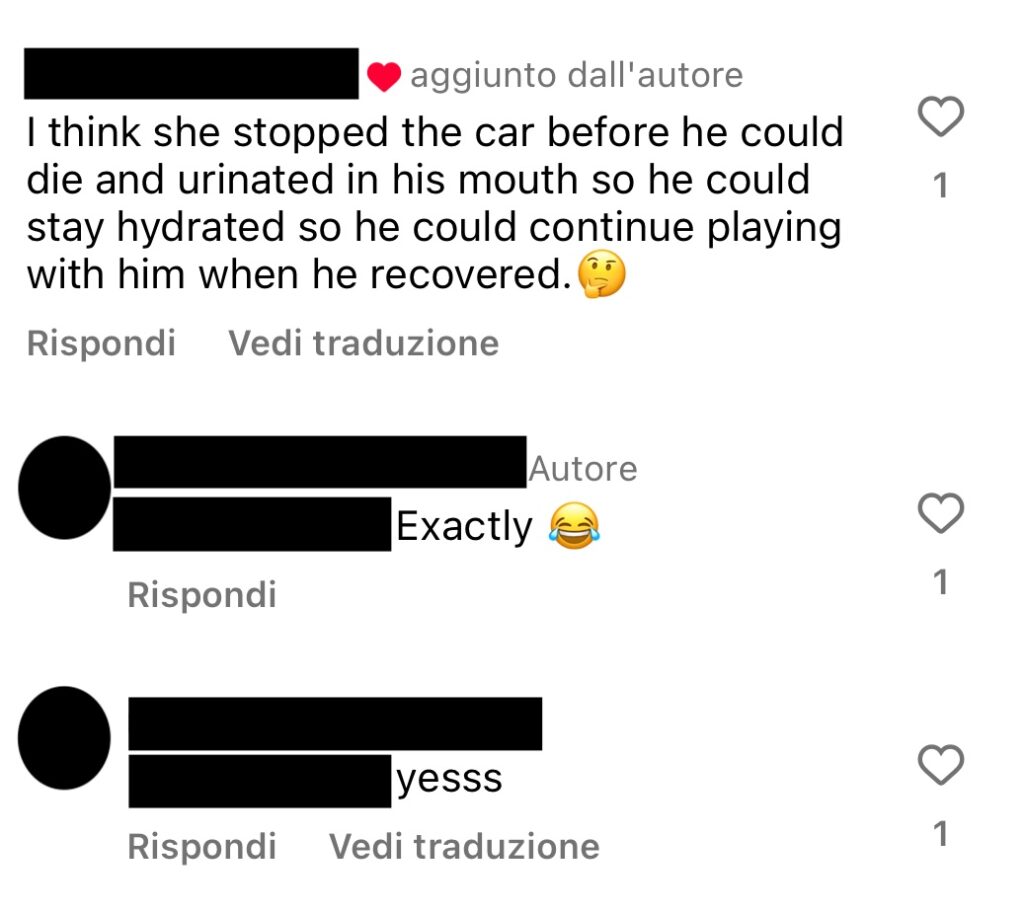

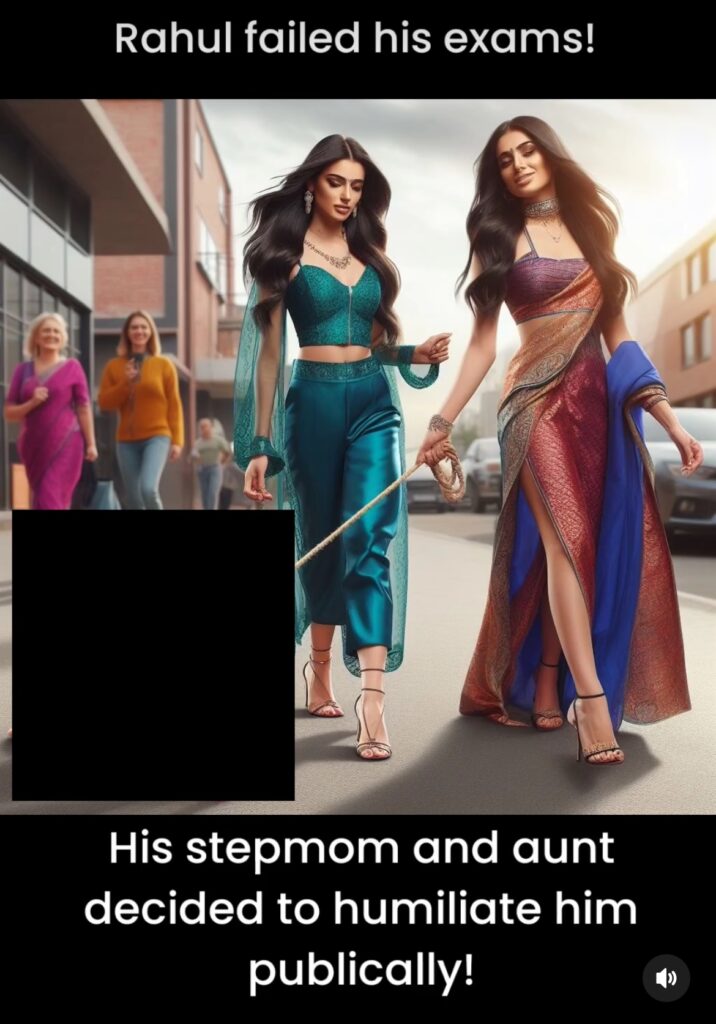

Molti dei contenuti ritraggono modelle occidentali ma molti altri ritraggono figure est-asiatiche: l’India è uno dei paesi maggiormente coinvolti nella diffusione di queste immagini. In molti casi, ad esempio, si trovano artefatti che richiamano la supremazia inglese su quella indiana, con scene di dominazione e violenza ai danni degli indiani. Si tratta di contenuti sviluppati proprio in India e che realizzano fantasie di dominazione che ora si riflettono anche sui bambini. Ovviamente tutti questi materiali ricevono commenti favorevoli con poche eccezioni: un caso tra tutti è stato quello di una foto nella quale un bambino viene trascinato per un guinzaglio legato ad un’automobile: i commenti sono piuttosto espliciti.

Anche in questo caso è un canale indiano ad aver prodotto l’immagine, nonostante le modelle abbiano un aspetto occidentale. Fondale, tipologia di auto e nome del canale (nonchè il resto dei contenuti) allude all’India come paese di generazione. Un altro esempio, opportunamente censurato, è quello riportato di seguito.

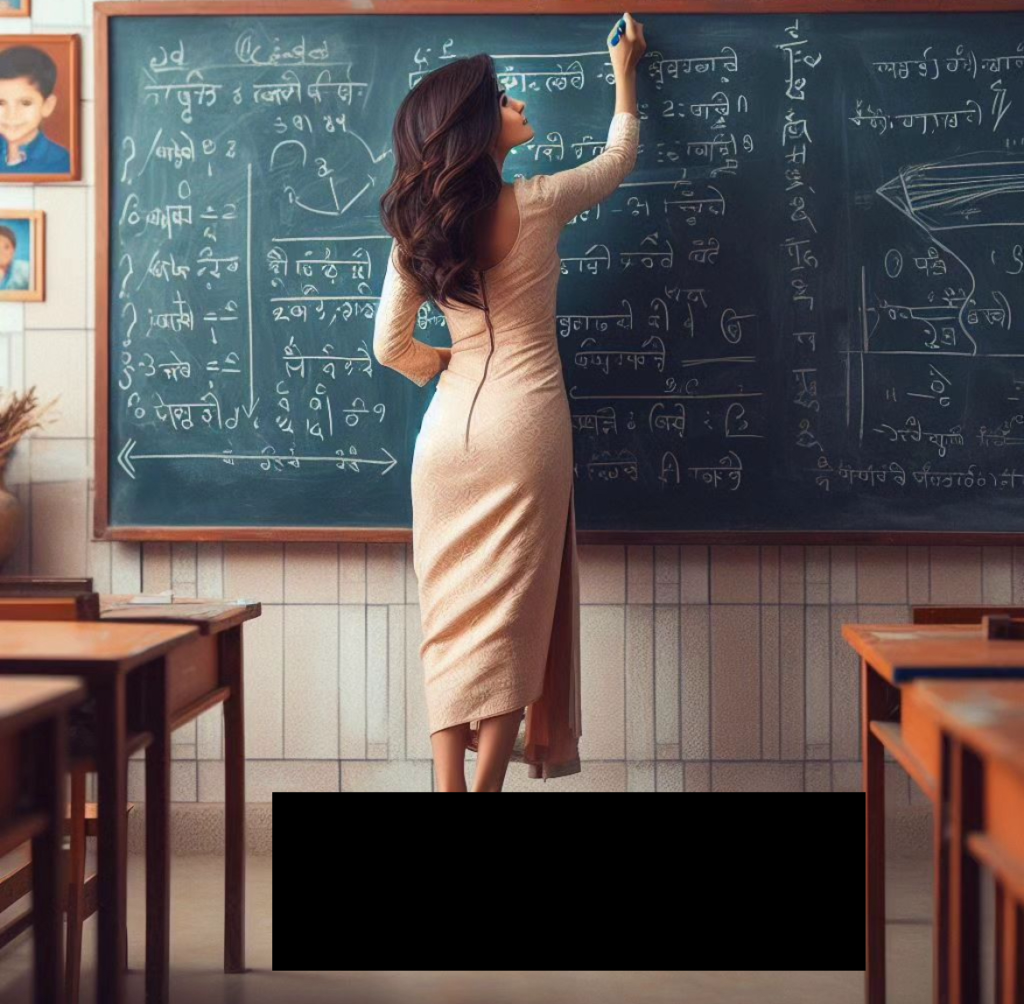

Spesso i personaggi di queste immagini sono ricorrenti: così come il piccolo Rahul è la vittima sacrificale di più immagini, le sue maestre e le sue matrigne mantengono spesso gli stessi nomi e le stesse “caratteristiche comportamentali” come se fossero persone reali. Questo, tra l’altro, consente di stimare una preferenza su quale personaggio il pubblico preferisca.

L’influenza culturale

Non sarà sfuggito che alcune di queste immagini sono ambientate in contesti scolastici: la cultura indiana attribuisce un’enorme importanza all’educazione e agli educatori. Gli insegnanti sono visti come secondi solo ai genitori nella formazione del carattere e nella trasmissione della saggezza. Questo rispetto è spesso manifestato in occasioni come la festa del “Guru Purnima”, un giorno dedicato a onorare i guru e gli insegnanti. Queste immagini hanno quindi una forte presa culturale sulla massa e fanno perno su una discriminazione insita nei ruoli sociali.

Tale fenomeno discriminatorio, operato anche ai danni di minoranze sociali (omosessuali, persone trans) e di altre religioni è stato trattato in un articolo dell’Indian Express e meriterebbe un approfondimento. L’autore dell’articolo scrive: “Inciderà direttamente sulle persone che vivono ai margini: i Dalit, i musulmani, le persone trans. Ciò aggraverà i pregiudizi e la discriminazione nei loro confronti”, ha affermato Shivangi Narayan, un ricercatore che ha studiato la polizia predittiva a Delhi.“

La discriminazione è quindi ricercata e praticata con una puntualità chirurgica, grazie alla generazione a comando di immagini artefatte dal forte significato socio-politico.

Non solo intelligenza artificiale

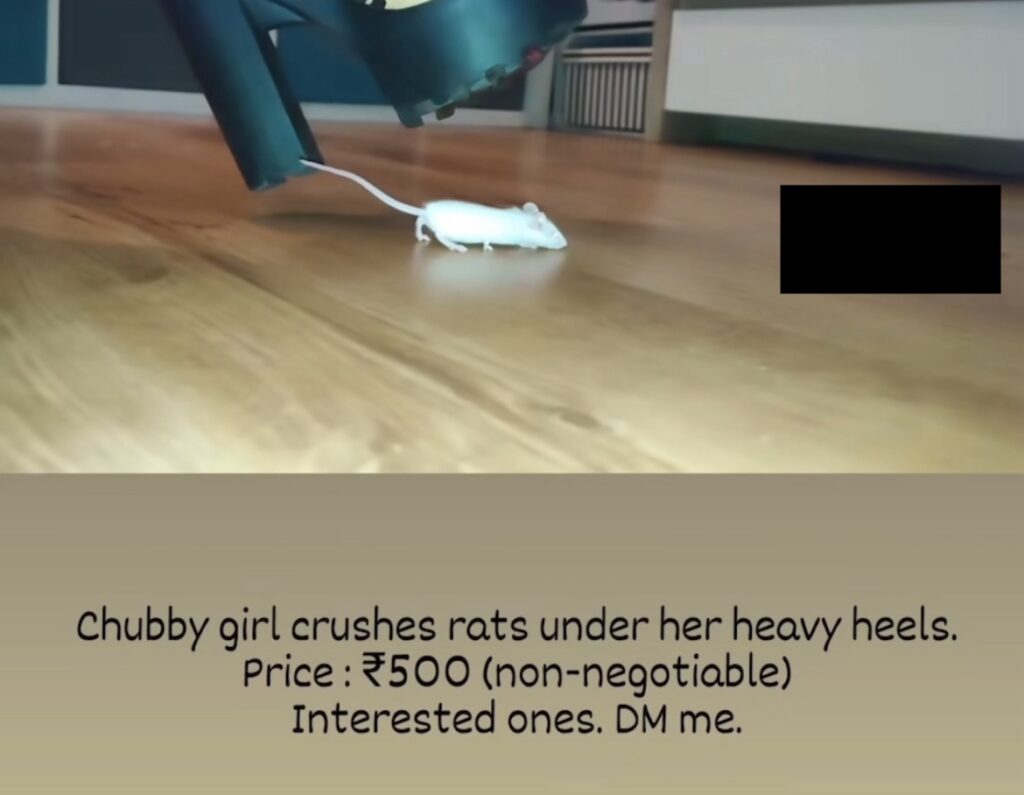

Purtroppo il fenomeno è andato ben al di là della realizzazione d’immagini artefatte e si è spinto sino alla pubblicazione e diffusione di video a pagamento con violenza su animali.

È il caso del video ai danni di due povere cavie, pubblicizzato su Instagram all’interno di un canale di generazione d’immagini mediante intelligenza artificiale. Il video è reale così come le due cavie la cui fine è fin troppo evidente. Non sfugga il dettaglio del messaggio, il cui prezzo è di 500 rupie indiane. Si tenga presente che 500 rupie indiane sono, al momento della scrittura di questo articolo, 5,58 euro il che consente a chiunque di accedere questi video e raddoppiarne l’offerta chiedendone altri fatti in modo personalizzato.

Il secondo caso riportato in foto è quello di Myg (nome di fantasia): una ragazzina che viene ritratta in varie posizioni da qualcuno a lei molto vicina, per poi essere scontornata dal contesto e inserita in uno scenario di dominazione infantile. Si tratta di letterali foto-montaggi in cui Myg si diverte a compiere azioni di dominazione ai danni di suoi pari o di adulti e anziani. Il problema del caso Myg è che non ci sono solo fotografie ma anche video in cui la ragazzina, ad esempio, calpesta orsacchiotti o altri peluches e il telefono viene tenuto direttamente da lei. Nel caso Myg l’origine sembrerebbe essere l’occidente e non l’oriente.

Gli algoritmi non funzionano: bisogna segnalare

L’algoritmo di censura non ha funzionato e non sta funzionando correttamente: benchè in questo articolo si è ritenuto di non pubblicarle nemmeno censurate, si prega di credere che esistono centinaia d’immagini artefatte di violenza ai danni di minori. Si tratta di una tendenza da non sottovalutare che dimostra quanto siano inefficaci i sistemi di moderazione automatica che, negli ultimi 6-7 mesi, hanno permesso il fiorire di contenuti sempre più estremi.

In un consesso tenuto con l’amico Andrea Lisi si discuteva, tempo fa, degli algoritmi di censura e di come essi, seppur di ausilio, fossero completamente inefficaci ad operare autonomamente. Certamente rappresentano un risparmio economico per le aziende dei social network, ma il loro livello d’inefficienza è pari ai danni provocati dalla pubblicazione dei contenuti. La moderazione diffusa (quella effettuata tramite le segnalazione degli utenti) rimane un’ultima linea difensiva ma ha scarso impatto considerando che gli utenti più impressionanti preferiscono “andare via” dal canale social senza effettuare la segnalazione.

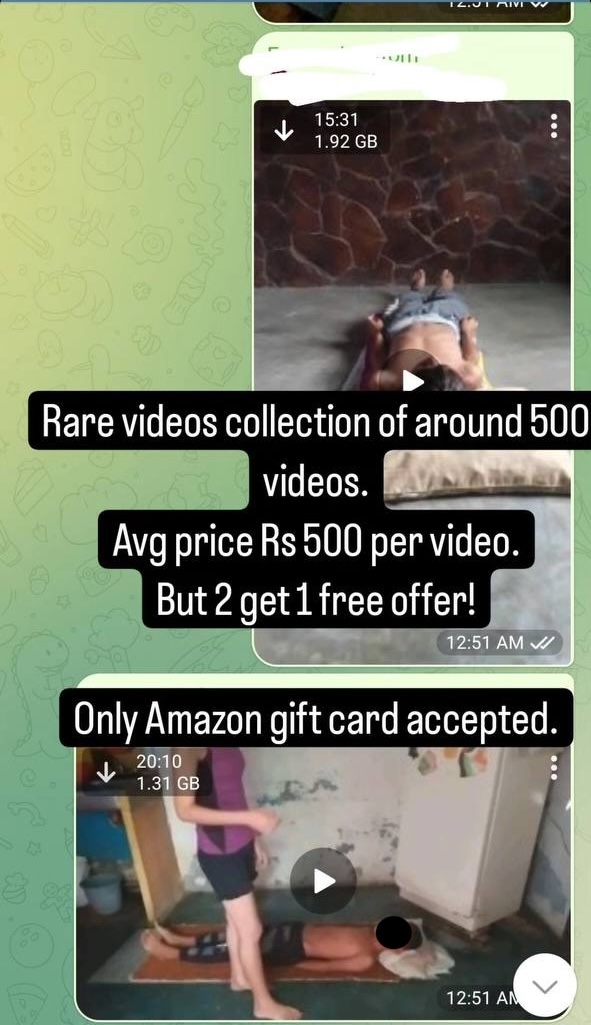

Le segnalazioni operate su Instagram non hanno sortito alcun effetto e da qualche giorno all’intelligenza artificiale, sono stati affiancati i “video su richiesta” utilizzando bambini in carne e ossa. La dimensione che si legge nello screenshot sembra potrebbe aiutare a stimare una durata ipotetica di 6-10 minuti per video compressi in H.264 con una risoluzione a 1080p.

Monitoraggio del caso U-1605

Il caso U-1605 riguarda un individuo che, da quanto risulta da una prima analisi, risiede in India e smercia materiale pedo-pornografico su Telegram facendosi pubblicità su Instagram. L’utente è mediamente attivo e propone la distribuzione di centinaia di video a soli 15 dollari americani (circa 1200 rupie nel luglio 2024). Molti di questi video hanno la durata inferiore al minuto e dalle anteprime non sembrano tutti avere contenuti sessuali. La maggior parte, tuttavia, si assesta tra i 4 e gli 11 minuti ed è in linea con quanto descritto sopra. Ci sono anche video specifici della dimensione di 15-20 minuti in cui sono coinvolti minori di 8-10 anni, in scene che potrebbero compromettere loro la salute e anche la vita (ad es.: mediante soffocamento per schiacciamento della gola con pesi 4 volte superiore al loro).

Si è deciso di effettuare un monitoraggio statistico del canale, al fine di mostrare il trend di crescita e sono stati presi in esame alcuni parametri, tra cui:

- Il numero degli iscritti

- Il numero delle foto pubblicate

- Il numero dei video pubblicati

Si è iniziato un monitoraggio mensile del trend per capire il “livello d’interesse” che gli utenti trovano nei confronti del canale, al fine di capire bene lo sviluppo del fenomeno. Tutte le informazioni saranno pubblicate in calce all’articolo. Bisogna fare una precisazione sul sistema di monitoraggio adottato da Telegram:le attuali norme di Telegram non parlano di violazioni pedo-pornografiche sui contenuti scambiati tra gli utenti. La violazione viene così descritta:

Tutte le chat e i gruppi di Telegram sono territorio privato dei loro rispettivi partecipanti. Non eseguiamo alcuna richiesta relativa ad esse. Tuttavia i set di sticker, i canali e i bot su Telegram sono disponibili pubblicamente. Se trovi qualche set di sticker o bot su Telegram che ritieni illegale, per favore contattaci a abuse@telegram.org. […]

Fonte: Telegram (Link)

In tutta franchezza, sembrerebbe che Telegram si preoccupi più della violazione dei copyright che di evitare la diffusione di materiale pedo-porongrafico.

Conclusioni

Generare queste immagini è facilissimo, pensare di realizzarle nella vita reale è pressoché impossibile: questo è un problema. La facilità di accesso a strumenti così potente può favorire lo sviluppo e la diffusione di contenuti estremi anche se non direttamente connesso ad una sfera sessuale. Il fatto che si tratti di immagini artefatte, anche di alta risoluzione grafica, può complicare il problema.

La speranza di una moderazione diffusa tramonta quando la parte algoritmica non viene curata a sufficienza da favorire la prima scrematura e la prima censura dei contenuti inopportuni. Di questo ci si dovrà occupare negli anni a venire, per evitare che la rete peggiori ulteriormente e diventi il bacino diffuso di contenuti estremi ed inappropriati.

È importante non demonizzare una tecnologia utile e potente quale è l’intelligenza artificiale che rimane uno strumento fondamentale per lo sviluppo tecnologico ed il miglioramento della vita. Era prevedibile che ci sarebbero stati casi di utilizzo per scopi non leciti o lesivi ma questo non dovrebbe impedirne lo sviluppo, bensì regolarne meglio l’applicazione.

A parer di chi scrive, il vero problema nella diffusione di queste immagini è ascrivibile a due fenomeni: il primo riguarda l’ipocrisia dei meccanismi di censura dei social che, per un seno nudo di una statua emettono una censura ma poi non vogliono/possono censurare fenomeni come quelli fin qui documentati e discussi.

Il secondo fenomeno, drammaticamente più preoccupante, è il meccanismo di abituazione a queste immagini. Man mano che diventeranno più frequenti, diffuse, condivise, esse susciteranno sempre meno preoccupazione, sdegno, paura, disapprovazione, rendendo il fenomeno (già ampiamente diffuso) più ignorato di quanto già non lo sia ora.

Aggiornamenti caso U-1605

Giugno 2024: sviluppo del canale Telegram

A seguito delle segnalazioni su Instagram il canale è stato chiuso ma successivamente l’utente ne ha aperto un secondo corredandolo di relativo gruppo Telegram. Questo avveniva nel giugno del 2024. Il gruppo è presto cresciuto in numero di utenti passando dai 23 utenti iniziali, agli oltre 1500 a distanza di circa un mese. Di seguito si pubblicano i dati statistici in forma grafica e tabellare.

| Data | Iscritti |

|---|---|

| 15/06/2024 | 23 |

| 26/07/2024 | 1575 |

Luglio 2024: chiusura e riapertura canale Telegram

Il giorno 26/07/2024 il canale Telegram dell’utente U-1605 è stato eliminato da Telegram dopo che, nei giorni precedenti, l’amministratore aveva pubblicato alcune fotografie e alcuni video illegali. È impressionante notare come, a distanza di poco più di un mese, ci sia stata una vertiginosa crescita degli utenti.

A seguito della chiusura del canale, ne è stato aperto subito un altro ma non segreto. Inizialmente alimentato con sole immagini generate da I.A. con scene di violenza su minori. Questo canale, il cui amministratore si firma con un tridente d’oro, conta solo 19 membri alla data del 26/07/2024 ore 21:50 circa.

L’utente è proprietario di vari account: il messaggio di acquisto riportato sotto la collezione d’immagini è il medesimo che appare per i filmati reali pedo-pornografici.